نفوذ هوش مصنوعی در زندگی روزمره افراد بیشتر میشود و سؤالاتی که مربوط به نحوه استفاده و به کارگیری آنها هستند نیز اهمیت بیشتری پیدا میکنند. یکی از پرسشها این است که چگونه میتوان رفتارهای انسان را در سیستم هوش مصنوعی پیادهسازی کرد؟ پاسخ به این پرسشها میتواند قابلیتهای اساسی که تصمیمهای بزرگ و کوچک در هوش مصنوعی را ایجاد میکند بهتر مشخص کند.

ترازبندی ارزشها

همسویی هوش مصنوعی به معنای این است که سیستمهای هوش مصنوعی مستقل باید طوری طراحی شوند که بتوان اهداف و رفتارهای آنها را با ارزشهای انسانی هماهنگ کرد. طبق تعریفی که آنکا دراگان، استادیار دانشگاه کالیفرنیا توضیح میدهد روباتها قصد ندارند علیه بشریت شورش کنند، آنها فقط سعی میکنند هر کاری را که ما به آنها میگوییم انجام دهند را بهینه کنند. بنابراین، باید آنها را طوری برنامهریزی کنیم که مطابق با دنیای ما باشند.

تیم OpenAI در مقاله تحقیقیشان، مفهوم همسویی ارزش هوش مصنوعی را به عنوان اطمینان از اینکه سیستمهای هوش مصنوعی به طور قابل اعتماد آنچه را که انسان میخواهد را انجام میدهد معرفی کردند. همسویی هوش مصنوعی مستلزم سطحی از درک ارزشهای انسانی در یک زمینه خاص است. در این مورد، تیم OpenAI معتقد است که بهترین راه برای درک ارزشهای انسانی، پرسیدن سؤالات ساده است.

پرسیدن سؤال درست، روشی مؤثر برای دستیابی به همسویی ارزش هوش مصنوعی است. متأسفانه، این روش یادگیری در برابر سه محدودیت قرار داد که عبارتند از:

۱) تعادل بازتابی: در بسیاری از موارد، انسانها نمیتوانند به یک سؤال که در حیطه قضاوت کردن است پاسخ درستی بدهند. عواملی مانند سوگیری شناختی یا اخلاقی، فقدان دانش در حوزه مربوطه یا تعریف مبهم از درستی ممکن است باعث ابهام در پاسخها شوند. در فلسفه، این مورد به نام تعادل بازتابی شناخته میشود، چرا که یکی از مکانیزمهایی است که هر الگوریتم هوش مصنوعی که سعی در یادگیری رفتارهای انسانی دارد باید از آن تبعیت کند.

۲) عدم اطمینان: حتی اگر بتوانیم به یک تعادل بازتابنده برای یک سؤال معین دست پیدا کنیم، ممکن است شرایط بسیاری وجود داشته باشد که در آن عدم اطمینان یا عدم توافق مانع از رسیدن انسان به پاسخ صحیح میشود. هر گونه فعالیتی که مرتبط با برنامهریزی برای آینده است اغلب دچار عدم اطمینان است.

۳) فریب: انسانها توانایی منحصر بفردی در ارائه پاسخهای قابل قبول به یک سؤال دارند اما ممکن است این پاسخ به طور ضمنی اشتباه باشد. این اشتباهات که ممکن است عمداً یا به طور اتفاقی باشد منجر به رفتارهای فریبنده یا گمراه کننده برای نتیجهگیری از یک رویداد معین شود. تشخیص رفتار فریبنده یکی از مهمترین چالشهای هوش مصنوعی است که برای دستیابی به ارزش همسویی هوش مصنوعی باید حل شود.

یادگیری رفتارهای انسانی از طریق بحث کردن

تا اینجا ما میتوانیم دو استدلال برای موضوع هم ترازی ارزش ارائه دهیم:

- سیستمهای هوش مصنوعی میتوانند ارزشهای انسانی را با پرسیدن سؤال یاد بگیرند.

- این سؤالات اغلب در برابر چالشهایی مانند عدم قطعیت، فریب یا عدم تعادل بازتابی آسیبپذیر هستند.

تیم OpenAI با کنار هم قرار دادن این دو ایده، تصمیم گرفت تا با تکیه بر روش پویایی در پاسخگویی به پرسشها یعنی مناظره، سیستم را وادار کند تا ارزشهای انسانی را بیاموزد. از نظر مفهومی، مناظره به معنای بحث کردن است و باعث میشود که یک استدلال پیچیده را به مجموعهای تکراری از سؤالات سادهتر تجزیه کند تا مسیر استدلالی به سوی یک پاسخ خاص را سادهسازی کند.

خطر تعصب

هوش مصنوعی یک سیستم مبتنی بر یادگیری است. از طریق دادههایی که ما به آن میدهیم رشد میکند و بینشها و قابلیتهای جدیدی را به دست میآورد. به منظور هدایت درست سیستم هوش مصنوعی، دانشمندان باید دقت بسیاری بر روی مجموعه دادهها داشته باشند. اما این دادهها به صورت ناخواسته ممکن است مورد تعصب قرار بگیرند.

به طور مثال، بر طبق تحقیقی که دانشمندان انجام دادهاند متوجه شدند که الگوریتم تبلیغاتی گوگل برای زنان ۶ برابر بیشتر از مردان آگهیهای مشاغل پردرآمد را نمایش میدهند. مطمئناً این موارد چالشی اساسی در هوش مصنوعی است. به همین منظور، ما باید یک چارچوب اخلاقی قوی برای هوش مصنوعی ایجاد کنیم و بر انتخابهایی که انجام میدهیم کنترل داشته باشیم.

افزایش هوش مصنوعی مسئول

برای استفاده از فرصتهای رشدی که هوش مصنوعی میتواند در اختیار ما قرار دهید، شما باید به ملاحظات اخلاقی اصلی بپردازید و مجموعهای از الزامات مبتنی بر ارزش را برای هدایت استقرار هوش مصنوعی ایجاد کنید. در ادامه ما چند رویکرد را ارائه میکنیم که میتواند به هوش مصنوعی مسئول کمک کند.

1- حکمرانی قوی: هوش مصنوعی باید مبتنی بر ارزشهای اصلی شما باشد. ایجاد یک حکمرانی قوی با حفاظهای اخلاقی روشن و چارچوبهای پاسخگویی به سیستم شما امکان شکوفایی بیشتر را میدهد.

2- طراحی قابل اعتماد: مصرف کنندگان تا جایی که بتوانند اقدامات و تصمیمات آن را توضیح دهند میتوانند به هوش مصنوعی کمک کنند. دستیابی به این اعتماد مستلزم حفظ حریم خصوصی، شفافیت و امنیت است.

3- نظارت مؤثر: هنگامیکه سیستم هوش مصنوعی شما منتشر شد نظارت به نحوه عملکرد آن برای موفقیت بسیار مهم است.

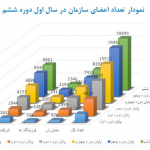

4- مهارت مجدد نیروی کار: معرفی هوش مصنوعی بر افراد درون سازمان نیز تأثیرگذار خواهد بود.

نظرات کاربران