روبات ها می توانند بسیار خطرناک باشند. این موضوعی است که اخیرا از سوی گروهی از پژوهشگران مطرح شده است.

به گزارش بادیجی ، اگر بگوییم قاتل بودن روبات ها عادی است، سخت در اشتباهیم. اما خبرها حکایت از آن دارند که روبات ها می توانند خطرناک باشند . ماجرا از چه قرار است؟ دانشمندان هشدار میدهند اگر کدنویسان توجه نکنند رباتها میتوانند به ماشینها کشتار دسته جمعی تبدیل شوند.

نگاهی به حدس و گمان ها در خصوص قاتل بودن روبات ها

_دانشگاه اوکلاهاما هشدار میدهد اگر کدنویسی روباتها درست انجام نشود، امکان دارد دچار افراطگرایی شوند

_افراط گرایی روبات ها به این معناست که ممکن است دست به کشتار تعداد زیادی از شهروندان جامعه بزنند

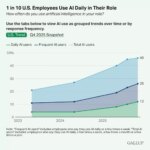

_جالب است بدانید برخی پژوهشگران نگران هوش مصنوعی روبات ها هستند

_پژوهشگران معتقدند اگر روبات ها به درستی طراحی نشوند می توانند دچار مشکلاتی جدی شوند

_سوبهاش کاک استاد مهندسی برق و کامپیوتر دانشگاه اوکلاهاما معتقد است اگر روباتها با دقت طراحی نشوند با انسان ها دچار حس خصومت می شوند

_برخی دیگر نظری کاملا متفاوت دارند. آنان می گویند با وجود تکنولوژی های فعلی، هیچ خطری تهدیدشان نمی کند. درواقع این گروه به شعار تکنولوژی علیه تکنولوژی معتقدند

این ادعاها روبات ها را بد نشان می دهد؟

برخی معتقدند روبات ها می توانند بد یا خوب باشند، اما در کنار این موضوع نمی توانیم از نقش موثر روبات ها در زندگی خود غافل شویم. رویات ها کارکردی شگفت انگیز در زندگی ما دارند.

روبات ها می توانند جایگزینی مناسب برای کارگران در جهت توسعه بسیاری از امور باشند.انسان ها تصمیم گیری هایی ساده تر دارند و روبات ها تصمیم گیری هایی پیچیده تر. بر همین اساس است که برخی تصور می کنند، اگر مغز ربات سوءعملی داشته باشد منجر به بروز رفتارهایی میشود که مانند افراطگرایی در انسانهاست.

در سالهای اخیر افراطگرایی باعث ایجاد گروهکهای تروریستی زیادی در سراسر دنیا شده است و این افراطگرایی در رباتها نیز میتوانند نتیجه مشابهی داشته باشد.

به گفته کاک، تنها یک ایراد کوچک در کدنویسی میتواند رباتها را تبدیل به یک ماشین کشتار دسته جمعی کند. اگر رباتها افراطگرا شوند، شرکتهای سازنده آنها سعی میکنند که تقصیر را گردن کس دیگری بیندازند.

برخی از متخصصان بر این باورند که هوش مصنوعی در چند دهه آینده چنان پیشرفت کند که از انسانها نیز باهوشتر شوند و هر شغل قابل تصوری را از انسانها بگیرند.

انتهای پیام/

نظرات کاربران